【生成AI パラメータ完全ガイド】5つの調整法と実践活用術

この記事でわかること

- パラメータとハイパーパラメータの違いと役割

- モデル性能に対するパラメータ数の影響とビジネスでの選び方

- 生成AIの出力品質を高めるパラメータ調整テクニック(温度・トークン数など)

- モデル選定時に重視すべきパラメータ評価基準と日本語特化モデルの特徴

- 少ないリソースでも効果を引き出すための最適化技術と将来展望

生成AIの性能を最大限に引き出す鍵は「パラメータ設定」にあります。

ChatGPTやGemini、Claudeなど、あらゆる生成AIの出力品質や応答速度は、パラメータ調整によって劇的に向上します。

本記事では、生成AIパラメータの基礎知識から実践的な調整テクニック、業種別の最適設定まで、初心者でも理解できるよう体系的に解説。

適切なパラメータ設定で、ビジネスにおける生成AI活用の効果を最大化しましょう。

目次

生成 AI パラメータとは?基本から理解する重要性

ChatGPTやGeminiなどの生成AIが普及する中、その性能を左右する重要な要素として「パラメータ」があります。

パラメータの理解と適切な設定が、生成AIを最大限に活用するための鍵となるのです。

AIモデルにおけるパラメータの定義と役割

パラメータとは、AI モデルが学習した情報を保持し、与えられた指示に対する出力を決定するための数値のことです。

生成AIの内部では、膨大な数のパラメータが言葉の意味や文脈、関係性などを表現する役割を果たしています。

例えば、単語間の関連性や言語的なパターンは、すべてパラメータという形で保存されています。

生成AIが「りんご」という単語を処理するとき、その意味、関連する概念(果物、赤い、甘いなど)、使用される文脈などがパラメータによって表現されているのです。

このようにパラメータは生成AIの「知識」そのものであり、パラメータの数が多いほど、より複雑なパターンや微妙な文脈の違いを理解できるようになります。

パラメータとハイパーパラメータの明確な違い

生成AIを理解する上で混同されやすい概念として、「パラメータ」と「ハイパーパラメータ」があります。

これらは明確に異なる役割を持っています。

パラメータは学習過程で自動的に調整される値であり、AIの知識を表現します。

一方、ハイパーパラメータは学習プロセスをコントロールする設定値で、開発者が事前に決定します。

例えば、学習率やバッチサイズ、ニューラルネットワークの層の数などがこれに該当します。

わかりやすく例えると、パラメータは「AI自身が身につけた知識や技能」であり、ハイパーパラメータは「AIの学習方法を設計するための人間側の設定」だと言えるでしょう。

ビジネスでAIを活用する際は、この違いを理解することで、適切なモデルの選択や調整が可能になります。

モデル性能を左右するパラメータの影響力

パラメータは生成AIの性能を決定づける重要な要素です。

一般的に、パラメータ数が増えるほど、モデルの表現力と汎化能力が向上します。

それにより、未知の質問に対しても適切に対応できる能力が高まるのです。

例えば、GPT-4やClaude 3などの最新モデルは、数千億以上のパラメータを持ち、より自然で精度の高いテキスト生成を実現しています。

この膨大なパラメータ数により、専門的な知識を要する分野でも人間に近い応答が可能になっています。

ただし、パラメータ数を増やすだけでは最適な結果は得られません。

パラメータの増加は計算コストやエネルギー消費の増大を伴うため、効率性と性能のバランスが重要です。

企業の実際の運用では、目的や予算に応じた適切なモデル選択が求められます。

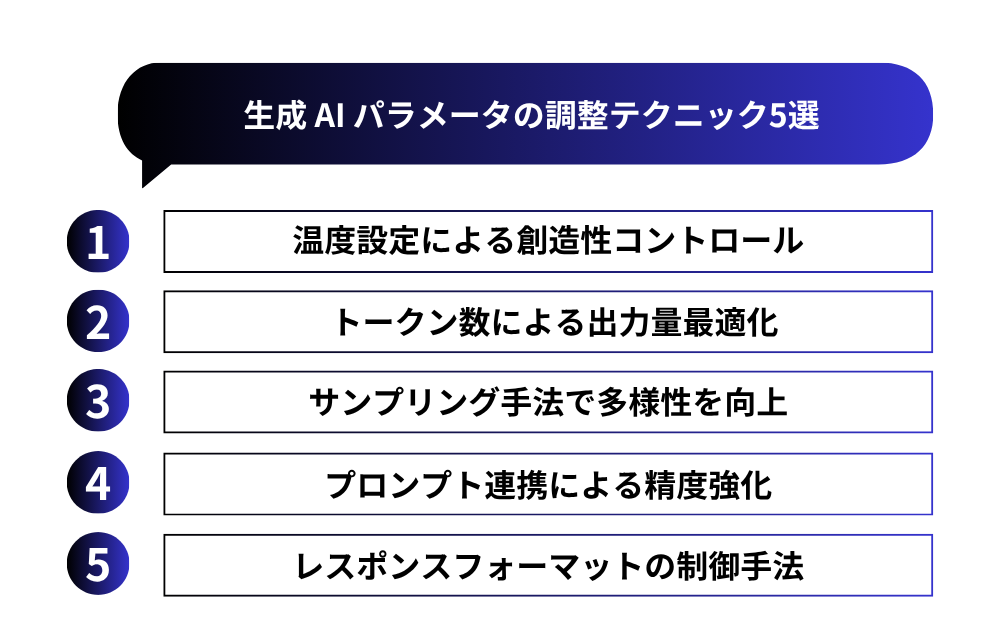

生成 AI パラメータの調整テクニック5選

生成AIの出力品質は、適切なパラメータ設定によって大きく向上します。

ここでは、ビジネスシーンですぐに活用できる5つの実践的なパラメータ調整テクニックをご紹介します。

これらを理解することで、AIツールからより価値の高い結果を引き出せるようになるでしょう。

パラメータ調整①:温度設定による創造性コントロール

「温度(temperature)」は、生成AIの出力におけるランダム性や創造性を制御する重要なパラメータです。

温度の値は一般的に0.0~1.0の範囲で設定され、値が低いほど決定論的で一貫性のある応答を、高いほど多様でクリエイティブな応答を生成します。

例えば、事実に基づいた正確な情報が必要な場合(財務レポート、技術マニュアルなど)は温度を0.0~0.3程度の低い値に設定します。一方、マーケティングコピーやストーリー作成など創造性が求められる場合は0.7~1.0の高い値が適しています。

ビジネスでの活用では、目的に応じた温度設定が効果的です。

会議の議事録作成には0.1程度、ブレインストーミングには0.8程度というように、タスクごとに適切な値を使い分けることで、AIの出力を最適化できます。

パラメータ調整②:トークン数による出力量最適化

「最大トークン数(max_tokens)」は、AIが生成するテキストの長さを制御するパラメータです。

トークンとは単語よりも小さい言語の単位で、英語ではおよそ単語4つで3トークン、日本語では2~3文字で1トークン程度に相当します。

ビジネスシーンでの効果的な設定としては、簡潔な回答が必要な場合(質問応答など)は50~100トークン、詳細な説明が必要な場合(レポートや分析など)は500~1000トークン程度が目安になります。

ただし、設定値が低すぎると情報が不足し、高すぎるとコストが増加して冗長な内容になりがちです。

また、モデルごとにコンテキスト長(一度に処理できるトークン数)の上限が異なるため、使用するモデルの仕様を確認することも重要です。

例えばGPT-4では8Kや32Kなど異なるバージョンがあり、長文処理が必要な場合は適切なモデルを選択する必要があります。

パラメータ調整③:サンプリング手法で多様性を向上

「サンプリング手法」は、AIがテキスト生成時に次の単語を選ぶ方法を制御するパラメータです。

主なパラメータとして「top_p(核サンプリング)」と「top_k」があります。

top_pは0~1の値を取り、確率の累積がこの値に達するまでのトークンのみを候補とします。

例えば0.9に設定すると、AIは確率上位のトークンのうち、合計確率が90%に達するまでのトークンから選択します。これにより、低確率の不自然な選択肢を除外しつつ、適度な多様性を確保できます。

一方、top_kは正の整数値を取り、確率順に上位k個のトークンのみを候補とします。

ビジネス文書では一般的にtop_p=0.8~0.9、top_k=40~50程度の設定が、品質と多様性のバランスを取るのに効果的です。

これらのパラメータは単独でも使用できますが、複数組み合わせることで、より精緻に出力の質をコントロールすることが可能になります。

パラメータ調整④:プロンプト連携による精度強化

プロンプト(AIへの指示文)とパラメータを連携させることで、出力の精度を大幅に向上させることができます。

この手法は「プロンプトエンジニアリング」とも呼ばれ、生成AIの性能を最大化する重要な要素です。

例えば、システムプロンプトでAIの役割や制約を明確に定義し、それに合わせて温度パラメータを調整することで、より目的に適した出力を得られます。

専門家の視点が必要な場合は、システムプロンプトで「あなたは〇〇の専門家です」と設定し、temperature=0.2~0.4の低めの値にすることで、信頼性の高い専門的な回答を引き出せます。

また、Chain-of-Thought(思考の連鎖)と呼ばれる手法では、AIに段階的な思考プロセスを促すプロンプトと、それに適した低めの温度設定を組み合わせることで、複雑な問題解決や論理的な分析の質を向上させることができます。

パラメータ調整⑤:レスポンスフォーマットの制御手法

生成AIからの出力を特定の形式(JSON、Markdown、HTML等)で得るためのパラメータ設定も重要です。

これらのパラメータは「response_format」や「output_format」などと呼ばれ、APIを通じて利用する際に特に有用です。

例えば、データ分析や他システムとの連携が必要な場合は、response_formatをJSONに指定し、temperatureを0.0~0.1の低い値に設定することで、構造化された一貫性のあるデータを取得できます。

Webコンテンツ作成時はHTMLやMarkdown形式で出力するよう指定すると、フォーマットの修正作業を省略できます。

ビジネスプロセスの自動化においては、これらのフォーマット制御が特に重要です。

AIの出力をデータベースやCRMなどの既存システムと連携させる場合、適切なフォーマット設定により、データの受け渡しがスムーズになり、余計な処理コストを削減できます。

主要な生成 AI パラメータ比較|モデル別特徴

各生成AIモデルはパラメータ数や構造が異なり、それぞれ独自の特性を持っています。

適切なモデル選択のためには、これらのパラメータの違いを理解し、ビジネス要件に最適なモデルを見極めることが重要です。

GPT・Claude・Geminiのパラメータ数と性能差

現在の主要な生成AIモデルは、そのパラメータ数と性能に明確な特徴があります。

OpenAIのGPT-4は推定1.76兆パラメータを持ち、汎用性と高度な推論能力に優れています。

一方、AnthropicのClaude 3 Opusは推定1兆パラメータ以上を持ち、特に長文理解や倫理的な応答において強みを発揮します。

GoogleのGemini 1.5 Proは推定数千億パラメータで、特にマルチモーダル(テキスト、画像、音声など複数の情報形式)の処理能力が高いことが特徴です。

注目すべきは、単純にパラメータ数が多いモデルが常に優れているわけではないという点です。

例えば、コード生成ではGPT-4が優位性を示す一方、複雑な指示理解ではClaude 3が優れた性能を発揮することがあります。実際の業務での活用では、タスクの特性に合わせたモデル選択が効果的です。

日本語特化モデルが持つパラメータの独自性

日本語に特化した国産生成AIモデルには、グローバルモデルとは異なる独自性があります。

例えば、Rinna、Stockmark、Sakura、Youriなどの国産モデルは、パラメータ数は海外大手モデルより少ないものの、日本語処理に最適化されています。

これらのモデルは、日本語の言語構造や表現、文化的コンテキストに関連するパラメータが強化されており、敬語や業界特有の専門用語、日本特有の文化的背景を考慮した応答が可能です。

特に金融、法務、医療など日本の規制や慣行に特化した領域では、これらの国産モデルが優位性を持つことがあります。

また、日本語データでの事前学習が充実しているため、日本企業の社内文書や顧客対応など、日本独自のビジネスコンテキストでの活用において高い精度を発揮することが期待できます。

最適なAIモデル選択のためのパラメータ評価基準

生成AIモデルを選択する際は、単純なパラメータ数ではなく、以下の評価基準を総合的に判断することが重要です。

まず「パラメータ効率性」に注目します。

これはパラメータ数あたりの性能を示す指標で、少ないパラメータでも高性能なモデルは運用コストが低く、効率的です。

次に「コンテキスト長」も重要な要素です。

長文の処理が必要な場合は、より多くのトークンを一度に処理できるモデルが適しています。

さらに「ドメイン特化度」も考慮すべき点です。

汎用的なタスクには大規模な多機能モデル、特定業界や用途には特化型モデルという選択肢があります。

「ファインチューニング可能性」も、自社データでカスタマイズする必要がある場合は重要な判断基準となります。

最後に「コスト効率」も見逃せません。

API利用料金やインフラ要件などのランニングコストと性能のバランスを考慮し、ビジネス価値を最大化できるモデルを選択することが理想的です。

生成 AI パラメータ数と費用対効果の関係性

生成AIを企業活用する際、パラメータ数は性能と直結する一方でコスト増加も招きます。

最適な投資対効果を実現するには、パラメータ数と費用のバランスを理解し、ビジネス要件に応じた適切な選択が求められます。

パラメータ増加がもたらす精度と汎用性の向上

パラメータ数の増加は、生成AIモデルの精度と汎用性に直接的な影響を与えます。

AI研究では「スケーリングの法則」として知られる現象があり、パラメータ数を10倍に増やすと、モデルの性能は対数的に向上する傾向が観測されています。

例えば、数十億パラメータのモデルから数千億パラメータのモデルに移行すると、言語理解の微妙なニュアンスの把握や複雑な指示への対応力が格段に向上します。

この性能向上は、特に専門領域での応用において価値を発揮します。

法務、医療、金融などの専門分野では、背景知識の豊富さが正確な情報生成に直結するため、大規模パラメータモデルの優位性が顕著になります。

また、より少ないサンプルでの学習能力(few-shot learning)も向上するため、企業固有のデータが限られている場合でも効果的に活用できます。

ただし、パラメータ増加による性能向上には逓減効果があり、ある閾値を超えると投資対効果は低下します。

そのため、ビジネス価値と照らし合わせた適切なモデル選択が重要です。

リソース制約下での効率的なパラメータ設計

すべての企業が最大規模のAIモデルを活用できるわけではありません。

特に中小企業や予算制約のある組織では、限られたリソースで最大の効果を得るための効率的なパラメータ設計が重要になります。

この課題に対処するための有効な手法として「モデル蒸留」があります。

これは大規模モデルの知識を小規模モデルに転移させる技術で、パラメータ数を大幅に削減しつつ、元のモデルの性能を相当程度維持することが可能です。

例えば、1750億パラメータのモデルの性能を70億パラメータ程度まで圧縮できた事例もあります。

また「量子化」や「プルーニング」などの技術も有効です。

量子化はパラメータの数値精度を落とすことでモデルサイズを縮小し、プルーニングは重要度の低いパラメータを削除してモデルを軽量化します。

これらを組み合わせることで、計算リソースやメモリ要件を大幅に削減できます。

コスト削減と処理速度を両立させる最適化手法

生成AIの運用コストと処理速度を最適化するためには、モデル自体のパラメータ調整だけでなく、システム全体の設計も重要です。

効果的な最適化手法としては、まず「ハイブリッドアプローチ」が挙げられます。

これは単純な処理には小型モデル、複雑な判断が必要な処理には大型モデルを使い分ける方法で、全体のコストパフォーマンスを向上させます。

「キャッシング」も有効な手段です。

頻繁に出現する質問や応答をキャッシュしておくことで、同じ計算を繰り返す無駄を省き、応答速度を向上させながらコストも削減できます。

特に定型的な問い合わせが多い顧客サポートなどの用途では効果的です。

また「バッチ処理」の最適化も重要です。

複数のリクエストをまとめて処理することで、計算リソースの利用効率を高められます。

例えば夜間のバッチ処理で大量の文書要約を行うなど、リアルタイム性が求められない場合は特に効果的です。

これらの最適化手法を組み合わせることで、限られた予算内でも生成AIの性能を最大限に引き出すことが可能になります。

生成 AI パラメータの自動最適化技術と将来の展望

パラメータ調整の複雑さは生成AI活用の障壁となりがちですが、自動最適化技術の進化がこの課題を解決しつつあります。

ここでは最新の自動最適化技術とその将来性について解説し、企業がこれらの技術トレンドをどのように活用できるかを探ります。

AutoMLによるパラメータ自動調整の仕組み

AutoML(Automated Machine Learning)は、生成AIモデルの複雑なパラメータ調整を自動化する技術です。

従来は熟練したデータサイエンティストが試行錯誤で行っていたパラメータ調整を、アルゴリズムによって効率的に実行します。

その仕組みは主にベイズ最適化、進化的アルゴリズム、勾配降下法などの手法に基づいており、膨大なパラメータの組み合わせから最適な設定を自動的に探索します。

例えば、温度(temperature)、top_p、最大トークン数などの複数パラメータを同時に最適化し、特定のタスクに対する最適な設定を発見します。

ビジネス現場では、Google Cloud AutoMLやAmazon SageMaker Autopilotなどのサービスを利用することで、専門知識がなくても高度なパラメータ最適化が可能になっています。

これにより、AIプロジェクトの立ち上げ時間が大幅に短縮され、より多くの企業がAI技術の恩恵を受けられるようになっています。

パラメータ効率化モデルの最新研究動向

パラメータ効率化に関する研究は急速に進展しており、より少ないリソースで高いパフォーマンスを実現する新たなアプローチが次々と登場しています。

注目すべき研究トレンドの一つが「Mixture of Experts (MoE)」です。

これは膨大なパラメータをすべて同時に使うのではなく、入力に応じて適切な「専門家」サブモデルを選択的に活用する手法です。

GoogleのSwitch Transformerはこの技術を採用し、計算効率を大幅に向上させています。

また「Parameter-Efficient Fine-Tuning (PEFT)」も重要な研究領域です。

従来のファインチューニングではモデル全体のパラメータを調整していましたが、PEFTでは少数の追加パラメータのみを調整することで、効率的にモデルをカスタマイズします。

これにより、限られた計算リソースでも高度なモデルカスタマイズが可能になっています。

これらの研究は、将来的に企業がより少ないコストで高性能な生成AIを活用できる土台を築いています。

少ないパラメータで高性能を実現する最新技術

実用レベルで少ないパラメータながら高性能を実現する技術も続々と登場しています。

その代表例が「低ランク適応(LoRA)」です。

この手法は大規模言語モデルの重み行列に低ランクの更新のみを適用することで、パラメータ数を劇的に削減しながらファインチューニングを可能にします。

例えば、GPT-3のような大規模モデルを数百万パラメータの調整だけでカスタマイズできます。

「プロンプトチューニング」も注目の技術です。

これはモデルのパラメータ自体は変更せず、入力プロンプトを最適化することで性能を向上させます。

特定のタスク用に設計された「ソフトプロンプト」を使用することで、モデル調整なしで特定領域の性能を大幅に向上できます。

さらに「量子化技術」の進化も著しく、32ビット精度のパラメータを4-8ビット表現に圧縮しながらも性能をほぼ維持する手法が実用化されています。

これにより、同じハードウェアでより大きなモデルを動作させることが可能になり、コスト効率が大幅に向上しています。

これらの技術は、特に中小企業や計算リソースが限られた環境での生成AI活用を加速させる原動力となるでしょう。

まとめ:生成 AI パラメータを使いこなして業務効率と品質を向上させよう

本記事では、生成AIのパラメータの基本から応用までを解説しました。

パラメータは生成AIの「頭脳」であり、適切な調整が質の高いAI活用の鍵となります。

温度設定やトークン数調整などの基本テクニックから、サンプリング手法やレスポンスフォーマット制御といった高度な手法まで、目的に応じた設定がビジネス価値を左右します。

モデル選択では、単純なパラメータ数だけでなく、効率性や特化性、コスト効果を総合的に判断することが重要です。

限られた予算でも、最適化技術を活用すれば高いパフォーマンスを実現できます。

生成AIを業務に取り入れる際は、基本的なパラメータ調整から始め、徐々に高度なテクニックを試すことで、業務効率と成果物の品質を大きく向上させることができるでしょう。

【生成AI活用でお困りではないですか?】

株式会社アドカルは主に生成AIを活用したマーケティング支援や業務効率化に強みを持った企業です。

貴社のパートナーとして、少数精鋭で担当させていただくので、

「生成AIを業務に活用したい」

「業務効率を改善したい」

「自社の業務に生成AIを取り入れたい」

とお悩みの方は、ぜひ弊社にご相談ください。

貴社のご相談内容に合わせて、最適なご提案をさせていただきます。

サービスの詳細は下記からご確認ください。無料相談も可能です。

この記事でわかることを1問1答で紹介

Q. 生成AIパラメータとは何ですか?

A. 生成AIにおける「パラメータ」は、モデルが学習を通じて蓄積した知識を数値で表現したもので、テキストの意味や文脈、言語パターンの理解を支えています。

Q. パラメータとハイパーパラメータの違いは?

A. パラメータはAIが自動で学習する「知識」であり、ハイパーパラメータは学習方法を設計する「設定」です。前者はモデルの中身、後者は開発者が調整する外側の条件です。

Q. 出力の質を変えたい時はどうすればいい?

A. 温度(創造性の制御)や最大トークン数(出力量の上限)などのパラメータを調整することで、ビジネス用途に応じた最適な出力が得られます。

Q. モデル選びでパラメータ数はどう見ればいい?

A. パラメータ数が多いほど性能は高い傾向にありますが、用途に合った「効率性」や「特化性」も重要です。単に大規模なモデルが正解とは限りません。

Q. 小規模でも高性能に使う方法はありますか?

A. モデル蒸留や量子化、LoRAなどの技術により、パラメータ数を抑えつつ高精度を維持する方法があり、コストを抑えて効果を最大化できます。